Google lanza Project Gameface en Android, una tecnología que permite controlar aplicaciones y juegos con la cara

Los usuarios podrán configurar su experiencia de uso de esta tecnología, personalizando las expresiones faciales, el tamaño de los gestos o la velocidad del cursor

Google ha anunciado el lanzamiento de Project Gameface en Android, el «ratón» que permite controlar aplicaciones y juegos con movimientos de la cara y expresiones faciales, que ya está disponible en código abierto para los desarrolladores de Android, de cara a mejorar la accesibilidad en los dispositivos con este sistema operativo.

En el marco de su evento anual para desarrolladores Google I/O, el gigante tecnológico anunció sus últimas novedades relacionadas con la Inteligencia Artificial (IA), además de con su sistema operativo Android.

Entre las novedades compartidas, Google ha anunciado que ha lanzado la tecnología de Porject Gameface en Android, de manera que permitirá a los usuarios controlar aplicaciones con la cara y las expresiones faciales.

Herramienta de código abierto

Project Gameface es una herramienta de código abierto que Google anunció en el evento Google I/O del pasado año. Tal y como lo define la compañía, es un «ratón» que permite a los usuarios controlar el cursor de un ordenador mediante el movimiento de la cabeza y distintas muecas.

Es decir, esta tecnología posibilita que los usuarios controlen, por ejemplo, un juego levantando las cejas para hacer clic, o abriendo la boca para mover el cursor. Todo ello con el objetivo de hacer más accesible el uso de la tecnología para personas con dificultades de movimiento o enfermedades como la distrofia muscular.

Ahora, Google ha compartido que la fuente de código de esta tecnología está abierta para que los desarrolladores puedan comenzar a crear aplicaciones de Android, con este sistema de control.

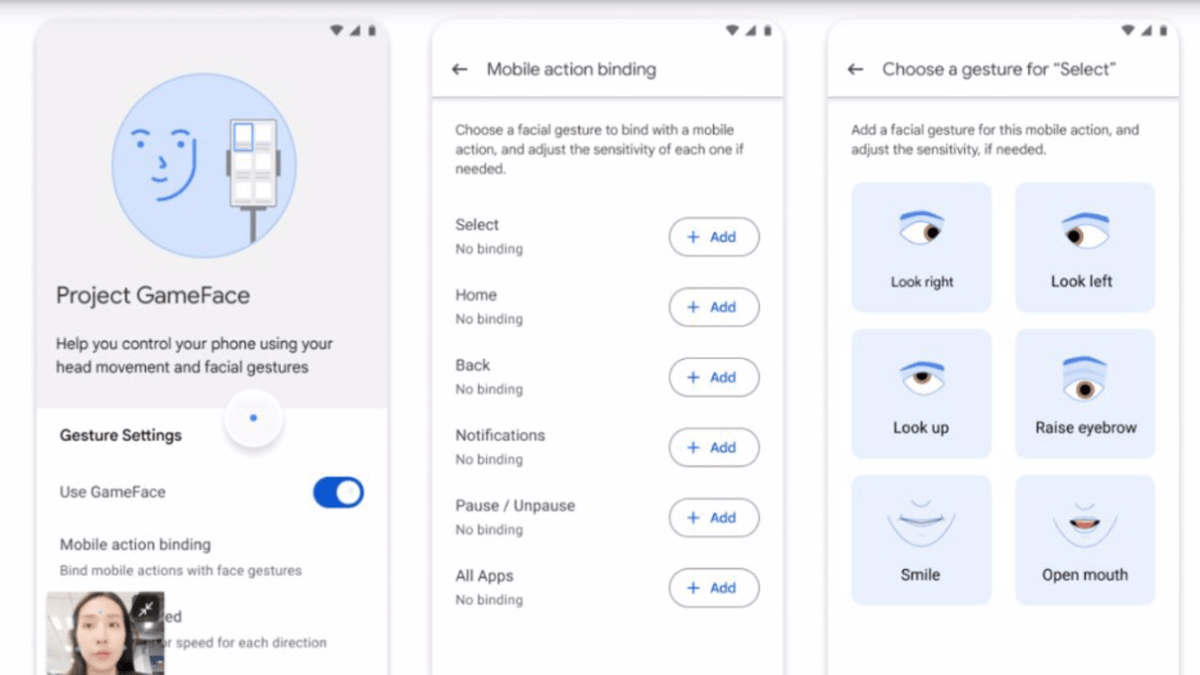

Así, tal y como ha explicado en un comunicado en su blog, la compañía ha replicado la idea de mover el cursor del ordenador con la cabeza y la ha integrado en los smartphones Android. Con ello, se podrán utilizar la cámara frontal del dispositivo en cuestión para analizar las expresiones faciales y movimientos de la cabeza de los usuarios, traduciendo estos gestos en un control «intuitivo y personalizado».

Podrán configurar su propia experiencia

De hecho, los usuarios podrán configurar su experiencia de uso de esta tecnología, personalizando las expresiones faciales, el tamaño de los gestos o, incluso, la velocidad del cursor, entre otras opciones.

Por un lado, para integrar Project Gameface en Android, Google ha indicado que han utilizado el servicio de accesibilidad del sistema operativo para «crear un nuevo cursor». Por otra parte, también han aprovechado la API de detección de puntos de referencia faciales de su servicio MediaPipe, para programar el cursor de manera que se traslade por la pantalla de acuerdo con el movimiento de la cabeza del usuario.

Además, esta API es capaz de reconocer 52 gestos faciales, como levantar las cejas, abrir la boca o guiñar un ojo. Por tanto, Google ha utilizado estos gestos para «mapear y controlar una amplia gama de funciones».

De esta manera, además de los juegos, las aplicaciones para Android que incluyan Project Gameface posibilitarán, por ejemplo, escribir en plataformas de mensajería instantánea controlando el cursor con los movimientos de dirección de la cabeza.

Con todo ello, Google ha reiterado que el código de Project Gameface «ahora es de código abierto en Github», por lo que cualquier usuario puede acceder a él para implementarlo en sus aplicaciones y «hacer más accesible los dispositivos Android».